Du phishing aux arnaques aux faux virements, l'ingénierie sociale fait rage.

La manipulation des utilisateurs est responsable d’un grand nombre de cyberattaques et la situation ne va pas en s’améliorant.

En parallèle, le développement rapide des grands modèles de langages ou LLMs et de l’IA générative de ces derniers temps laisse songeur quant aux possibilités que cela ouvre aux cybercriminels.

L’IA peut être utilisée à différents niveaux pour rendre ces attaques plus dévastatrices. Elle permet aux attaquants d’augmenter la difficulté de détection, l’efficacité de la manipulation et de changer d’échelle.

C’est ce que nous allons voir dans cet article.

Les ressorts de l’ingénierie sociale

L’ingénierie sociale utilise des leviers de manipulation pour induire des comportements potentiellement dangereux et exploitables, qui n’auraient pas lieu autrement.

Entre autres, l’attaquant exploite certains leviers comme l’autorité, la curiosité, la peur ou l’urgence, de manière à influencer sa ou ses victimes.

Ces leviers ont pour objectif de court-circuiter le raisonnement et comportement rationnel attendu et potentiellement appris lors de programmes de sensibilisation, au profit de réactions instinctives, émotionnelles, plus dangereuses.

Par exemple, un email prétendant partager un document important au sujet d’augmentations salariales à venir entraînera bien souvent l’ouverture de la pièce jointe. Celle-ci est motivée par la curiosité et un potentiel appât du gain et ne fera que trop peu souvent l’objet d’un examen approfondi de l’expéditeur ou de la vraisemblance d’un tel partage.

Détecter ces attaques revient à aiguiser son esprit critique et des réflexes de suspicion qui permettent de solliciter son système cognitif et analyser plus en profondeur les communications et indices qu’ils peuvent présenter.

En revanche, le développement des IA génératives et des LLM complexifie cette tâche.

L’IA permet d’augmenter la difficulté de détection des attaques

Les récents progrès dans le domaine de l’intelligence artificielle et la démocratisation des technologies telles que les LLMs et l’IA générative amènent un grand nombre d’opportunités — et de dangers — en cybersécurité.

Voici ceux qui me paraissent les plus dangereux.

Phishing Conversationnel

Un concept qui nous est cher chez Arsen est le phishing conversationnel.

En effet, un phishing “classique” est un email contenant un lien ou une pièce jointe contenant une charge active (ou payload) permettant l’obtention d’un accès initial.

Ces phishings restent efficaces aujourd’hui mais les systèmes de protection s’améliorent : authentification sans mot de passe, sandboxes, filtres intelligents, etc.

En revanche tout ce qui repose sur la conversation, c'est-à-dire des intéractions en apparence anodines, est bien plus difficile à détecter.

Et c’est là ou les LLMs excellent.

Prenez ChatGPT : capable de vous répondre dans de nombreuses langues différentes, vous pouvez avoir une conversation soutenue, sans indice évident qu’il s’agit d’un programme informatique.

Si cette conversation utilisait l’ingénierie sociale et avait pour objectif d’extraire des informations sensibles ou de vous manipuler afin de vous faire effectuer des actions potentiellement compromettantes, il serait extrêmement difficile de détecter l’attaque de manière programmatique.

Alors oui, ChatGPT et l’API d’OpenAI disposent de certaines sécurités qui l’empêchent de se transformer en dangereux manipulateur, néanmoins la boîte de pandore est ouverte.

Des LLMs offensifs comme WormGPT ou FraudGPT voient le jour et le coût de développement de LLM spécialisé, partant d’une base Open Source diminue de jours en jours.

Nous sommes donc à l’aube d’escroqueries à large échelle, faiblement détectables avec les moyens de protection conventionnels.

Création de contexte : fausses identités, renforcement de prétexte…

Toute attaque par ingénierie sociale commence par la création d’un prétexte justifiant la demande de l’attaquant.

L’attaquant doit rendre sa demande plausible aux yeux de sa victime et donc créer un contexte favorable : une fausse identité, une situation justifiant sa demande — de virement, d’information confidentielle, d’action de la part de sa victime…

Or, la création de contexte est une opération qui peut être fastidieuse et certaines tentatives d’attaque deviennent évidentes lorsqu’on effectue une recherche approfondie autour de la prétendue identité de l’attaquant.

L’IA générative permet ici la création d’un contexte beaucoup plus fouillé, profond et réaliste.

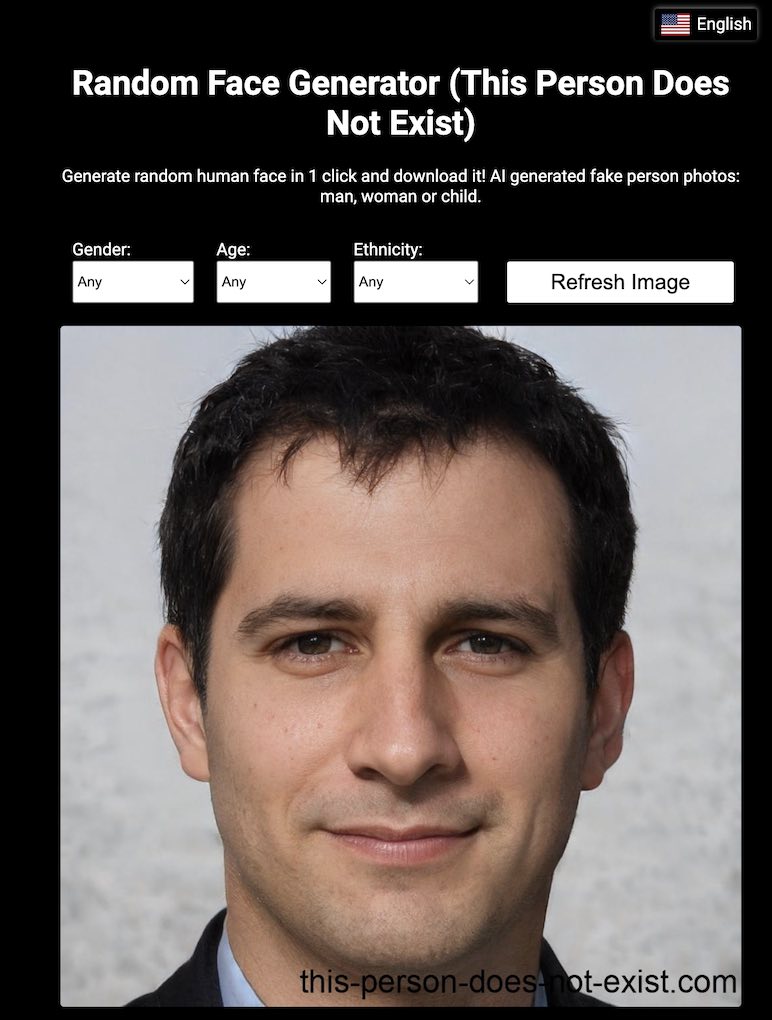

Par exemple, afin de créer un faux profil sur un réseau social, de nombreux attaquants réutilisent des profils existants et volent les photos de profil de personnes existantes.

Une recherche par image inversée permettait alors de détecter la tentative et de prendre les mesures adéquates.

Grâce aux Réseaux Antagonistes Génératifs — ou Generative Adversarial Networks, GAN — il est maintenant possible, facile et peut coûteux de générer de fausses photos de profil.

Des sites comme ThisPersonDoesNotExist permettent en quelques secondes de générer une photo de profil qui pourra être utilisée pour créer des faux profils crédibles, sans détection par recherche d’image inversée.

Il est également possible de générer des sites entiers, ainsi que du contenu afin de donner plus de crédibilité à un faux profil d’entreprise.

Animer un réseau de sock puppets est également maintenant beaucoup moins coûteux.

Un sock puppet est une fausse identité numérique qui peut être utilisée pour des opérations d’influence et de manipulation en ligne.

L’IA permet donc de rendre les attaques par ingénierie sociale beaucoup plus difficiles à détecter, mais cela ne s’arrête pas là.

En dehors du contexte et du vecteur utilisé, elle peut également augmenter l’efficacité et les chances de succès de ces tentatives.

L’IA permet d’augmenter l’efficacité de la manipulation

Non contente de rendre les attaques plus difficilement détectables, l’IA peut également les rendre beaucoup plus efficaces.

Le profiling et le pretexting utilisant l’IA

Comme nous le disions plus haut, la première phase d’une attaque par ingénierie sociale est la création d’un prétexte.

Il s’agit de créer un contexte qui permet de justifier et rendre crédible les demandes effectuées par l’attaquant.

Cette phase de recherche est un travail de préparation qui peut demander du temps et réduire drastiquement le retour sur investissement de telles attaques.

Grâce à l’IA et en particulier les LLM, il est désormais possible de générer des prétextes pertinents à large échelle.

Il n’y a qu’à voir les solutions d'email marketing ou de copywriting qui permettent de créer des emails à froid pertinents à partir d’un profil LinkedIn.

Ces prétextes sont non seulement pertinents, mais beaucoup moins coûteux à déployer à l’échelle, permettant de démultiplier l’impact des cyber attaquants en les faisant changer d’échelle.

Deep fakes et médias synthétiques

Un autre pan de l’IA générative est la création de médias synthétiques.

Nous avons brièvement parlé de fausses photos de profil plus haut mais l’IA générative ne s’arrête pas à cela.

Il est désormais facile et peu coûteux de créer des vidéos ou messages vocaux en changeant son visage et sa voix.

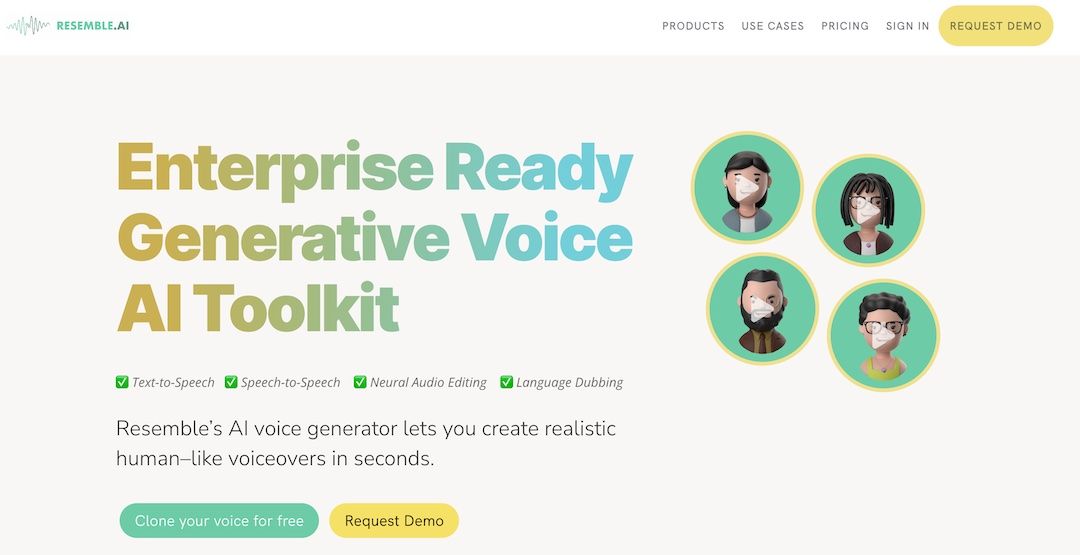

Le voice cloning permet par exemple d’usurper l’identité d’une personne et d’utiliser son autorité pour effectuer des demandes illégitimes.

Imaginez recevoir un appel de votre patron avec une demande urgente.

Une grande partie des processus de double vérification reposent sur un appel téléphonique, en estimant que l’on reconnaîtrait une tentative de fraude à la voix ou aux intonations de son interlocuteur.

Cette vérification est désormais beaucoup moins sûre.

Pour ce qui est des deep fakes vidéos, il est également possible de changer son visage pour usurper une identité en live.

L’identité de Patrick Hillmann, COO de Binance, aurait été utilisée via un deepfake dans une arnaque ciblant les fondateurs de cryptomonnaies.

Ces opérations sont pour le moment rares et anecdotiques. Elles restent marginales et coûteuses à déployer, mais comme toute progression technologique, le coût de déploiement tend à diminuer.

L’IA permet aux attaquants de changer d’échelle

Je ne vous apprends rien, il existe un grand nombre de d’attaques et tentatives d’arnaques différentes.

Certaines des plus dangereuses sont plus rares car elles demandent une main d'œuvre compétente et un investissement en temps conséquent.

Les attaques supportées par téléphone ou message vocaux, par exemple, demandent un opérateur :

- Capable d’adapter des scripts d’attaque à une conversation — donc une situation fluide, avec son lot d’imprévus

- Maîtrisant la langue de la victime

Pendant que l’attaquant est au téléphone avec sa victime, il ne s’attaque pas aux autres cibles potentielles.

En combinant des briques technologiques comme les LLM et leur capacité à comprendre et répondre dans un langage humain, le Text-to-Speech et le Speech-to-Text, convertissant du texte en message vocal et réciproquement, ces attaques auparavant limitées peuvent passer à l’échelle.

Avec la diminution des coûts de mise en place, il faut donc s’attendre à une augmentation drastique de ces attaques.

Conclusion

L’IA est un outil formidable avec des gains de productivité absolument géniaux à venir.

Néanmoins ces gains s’appliquent aussi bien à des utilisations légitimes que des activités illicites.

Sans en avoir peur, il faut pour autant se préparer à ce nouveau contexte de cybersécurité et ces nouvelles attaques qui ne manqueront pas de se développer.

Il est évident que l’IA fait évoluer le paysage des cybermenaces. Cet article se concentre sur son application à l’ingénierie sociale mais elle est également utilisée dans l’obfuscation de malware, la génération de charges actives inédites ou la création d’exploits.

Bien entendu, l’IA va également permettre de renforcer nos défenses. L’éternel jeu du chat et la souris ne s’arrête jamais entre cyber attaquants et cybersécurité.

Pour ce qui est de l’ingénierie sociale, outre les protections technologiques qui ne manqueront pas de se développer — elles aussi s’appuyant fortement sur ces nouvelles évolutions de l’IA — l’entraînement des utilisateurs ne peut plus être négligé.

En effet, l’élément humain reste agile et adaptable et il est de notre devoir de nous renforcer face aux tentatives de manipulation.

Malgré cette évolution impressionnante des attaques, les techniques de manipulation utilisées reposent sur les mêmes leviers psychologiques depuis la nuit des temps.

Et la bonne nouvelle est que nous pouvons nous entraîner et nous renforcer face à ces attaques dès maintenant, c’est la raison d’être d’Arsen.

C'est ce que nous faisons chez Arsen : nous proposons une solution basée sur des concepts de thérapies comportementales pour permettre de créer des réflexes de détection lorsque ces leviers sont utilisés pour nous manipuler.